Nou, we hebben bijna zeven maanden gewacht, maar het is eindelijk aangekomen (en wel midden in het vakantie-shoppingseizoen). Google heeft op 3 december 2020 weer een brede kernupdate uitgerold, en zoals we hadden verwacht, was het een enorme update. De laatste brede kernupdate was 4 mei 2020, dus we hebben bijna zeven maanden gewacht tussen de updates door. Ik zal binnenkort uitleggen waarom de tijd tussen de updates belangrijk is.

Een Big Update Warrants Een tweedelige serie:

Ik ging een bericht schrijven over de update, inclusief de casestudies, maar toen ik het schreef dacht ik dat een tweedelige serie veel beter zou passen. In dit eerste bericht zal ik een aantal belangrijke onderwerpen behandelen met betrekking tot de december-update en over brede kernupdates in het algemeen. Zo zal ik bijvoorbeeld de uitrol, de timing en de vroege beweging behandelen. Ik zal ook bevingen behandelen, die enkele omkeringen opleverden voor bepaalde websites. Vervolgens zal ik ingaan op (meer) belangrijke punten voor site-eigenaren om inzicht te krijgen in brede kernupdates, waaronder informatie uit mijn SMX Virtual-presentatie die zich richtte op brede kernupdates.

Vervolgens zal ik in deel twee van de serie vier casestudies behandelen die de complexiteit en de nuancering van de brede kernupdates van Google onderstrepen. Dat is in aanvulling op de vier die ik al heb behandeld in mijn bericht over de brede kernupdate van mei 2020. Elke case is uniek en geeft een interessant beeld van hoe bepaalde sites worden beïnvloed door deze updates en hoe site-eigenaren reageren. Ik sluit ook elk bericht af met tips en aanbevelingen voor site-eigenaren die zijn beïnvloed door de december-update (of een eventuele brede kernupdate trouwens).

Hier is een snelle inhoudsopgave als je naar een specifiek deel van dit bericht wilt springen. Ik raad aan om het van begin tot eind te lezen om alle context over brede kernupdates te begrijpen, maar ik begrijp dat iedereen kort op tijd is.

De Broad Core Update van december: Inhoudsopgave

- Uitrol en timing.

- Google Goldilocks en het Holiday Shopping Season.

- Sidderingen en omkeringen.

- Alternatieve Geneeskunde Impact.

- e-Commerce Beweging.

- Online Games, Lyrics, Coupons en andere sites met dezelfde of zeer vergelijkbare inhoud.

- (Meer) belangrijke punten voor site-eigenaren om te begrijpen over core updates.

- “De hel heeft geen woede zoals een gebruiker die wordt geminacht” en agressieve advertenties.

- Yo-Yo Trending en The Gray Area van Google’s Algorithms.

- Technische SEO problemen die kwaliteitsproblemen veroorzaken.

- Ontdek en Top Verhalen Zichtbaarheid.

- Inhoud is koning.

- De A in E-A-T.

- Site problemen en “De gebruikelijke verdachten”.

- Machine-leren en “Het hangt ervan af”.

- Tips en aanbevelingen.

Uitrol en timing.

Danny Sullivan kondigde de brede kernupdate aan op 3 december 2020 en koppelde deze aan Google’s eigen blogpost over kernupdates ter referentie. Kort daarna kondigde Danny aan dat de update begon uit te rollen om 1PM ET op 12/3 en dat de update een week of twee kon duren om volledig uit te rollen.

Later today, we are releasing a broad core algorithm update, as we do several times per year. It is called the December 2020 Core Update. Our guidance about such updates remains as we’ve covered before. Please see this blog post for more about that:https://t.co/e5ZQUAlt0G

— Google SearchLiaison (@searchliaison) December 3, 2020

En toen hoorden we eindelijk weer van Danny dat de uitrol op 12/16/20 klaar was. Dus dat is ongeveer twee weken om volledig uit te rollen, wat logisch was.

Later today, we are releasing a broad core algorithm update, as we do several times per year. It is called the December 2020 Core Update. Our guidance about such updates remains as we’ve covered before. Please see this blog post for more about that:https://t.co/e5ZQUAlt0G

— Google SearchLiaison (@searchliaison) December 3, 2020

Google Goldilocks en het Holiday Shopping Season. – Niet te vroeg, niet te laat, precies goed voor de meeste site-eigenaren.

De timing van deze update was een beetje controversieel. Sommigen dachten dat met de pandemie en de feestdagen op komst, dat Google niet zou moeten uitrollen zoals een grote update. Dat snap ik, maar er waren ook veel site-eigenaren die sinds de meibrede kernupdate hebben gewacht om herstel te zien. Heck, er waren er een aantal die geraakt waren door de januari-kern-update die in mei niet herstelde en die op deze update zaten te wachten. Dus hoewel ik beide kanten zie, ben ik in het kamp dat de timing eerlijk was.

In mijn SMX Virtual presentatie over brede core updates van 12/8 (wat een gekke timing was omdat het letterlijk vlak na de december update was uitgerold), legde ik uit dat Thanksgiving, Black Friday en Cyber Monday al voorbij waren. Dus, sites die negatief beïnvloed zouden kunnen worden door de december-core-update zouden kunnen hebben geprofiteerd van die grote winkeldagen, zelfs als ze zouden dalen. En voor degenen die wachten op herstel, ze miste die belangrijke winkeldagen sinds ze neer waren, maar kon mogelijk te herstellen voor de resterende vakantie winkelen seizoen. Het was natuurlijk lastig voor Google, maar ik denk dat de timing eerlijk was.

John Mueller over de Timing en de op Passage gebaseerde rangschikking

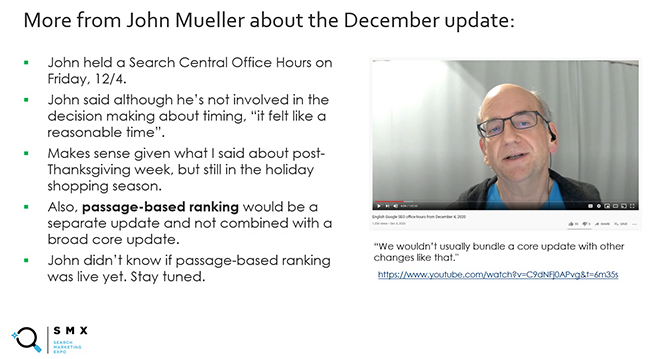

Het is ook het vermelden waard dat Google’s John Mueller in een Search Central Hangout (om 5:43 in de video) uitlegde dat hoewel hij niet betrokken was bij de beslissing over de timing, hij dacht dat het eerlijk leek. Hij beantwoordde ook een vraag over passage-gebaseerde rangschikking en of het uitrolde met de december-update. John legde uit dat een verandering zoals passage-gebaseerde rangschikking typisch niet zou worden gebundeld met iets als een brede kernupdate. Hij geloofde ook nog niet dat het uitrolde, hoewel Google had uitgelegd dat het voor het einde van het jaar kon worden uitgerold. Dus blijf op de hoogte van de passage-gebaseerde ranking. Hier is mijn slide van SMX over:

De kernupdate van december 2020: Interessante opmerkingen van de frontlinies

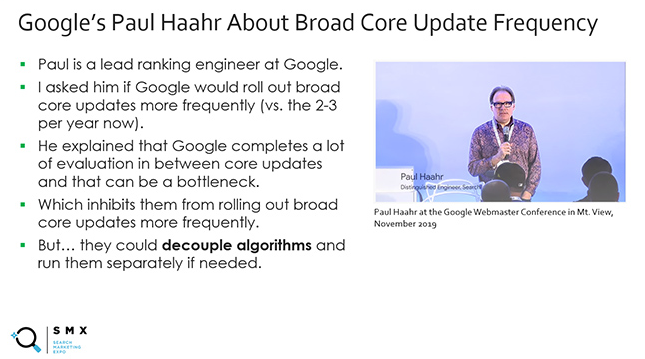

Google kijkt naar vele factoren met brede kernupdates, en over een langere periode. Ze hebben dit vele malen uitgelegd en ik heb dit vaak gedeeld op Twitter, in presentaties, in mijn blogberichten over kernupdates, etc. Google’s Paul Haahr, een lead ranking engineer bij Google, legde bijvoorbeeld uit op de webmasterconferentie in Mt. View dat ze een buitengewone hoeveelheid evaluatie uitvoeren tussen de brede core-updates door. Eigenlijk doen ze zoveel evaluatie tussendoor dat het een knelpunt kan zijn om ze vaker uit te rollen. En controleer het laatste punt over het ontkoppelen van algoritmen en het apart uitvoeren ervan. Yep, welkom bij SEO. 🙂

Google probeert een site te begrijpen in het algemeen, en over vele factoren heen. Daarom is het erg moeilijk om specifieke dingen te identificeren die met brede kernupdates zijn veranderd. En het is ook de reden waarom het moeilijk is om precies te weten wat er aan de hand is met een bepaalde website, tenzij je er aan werkt, de volledige geschiedenis van de site begrijpt, de problemen die het had in de loop van de tijd, verbeteringen die zijn geïmplementeerd, enz.

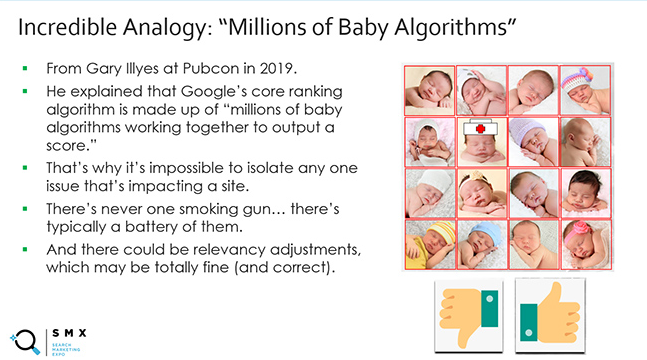

In mijn bericht over de kernupdate van mei vertelde ik hoe Google’s Gary Illyes uitlegt dat het kernrangschikkingsalgoritme van Google bestaat uit “miljoenen babyalgoritmen die samenwerken om een score uit te voeren”. Dat is super belangrijk om te begrijpen en het is waarom je je niet kunt richten op slechts een of twee dingen bij het analyseren en verbeteren van je site. Het is veel breder dan dat, woordspeling bedoeld. Mijn slide van SMX Virtual onderstreepte dit punt:

Daarom heb ik in mijn bericht over de kernupdate van mei 2020 ook vier casestudies gegeven, die de complexiteit en de nuancering van brede kernupdates onderstreepten. In deel twee van deze reeks zullen nog vier casestudies worden behandeld die gebaseerd zijn op de december-update.

Ik wilde alleen maar de complexiteit van de brede kernupdates naar voren brengen, zodat u zich niet te eng concentreert bij het beoordelen van uw site of andere sites die werden beïnvloed.

Snelle beweging, heel snel, bijna te snel:

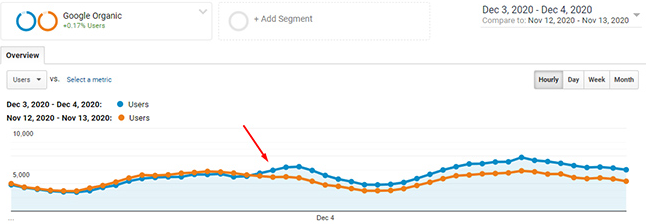

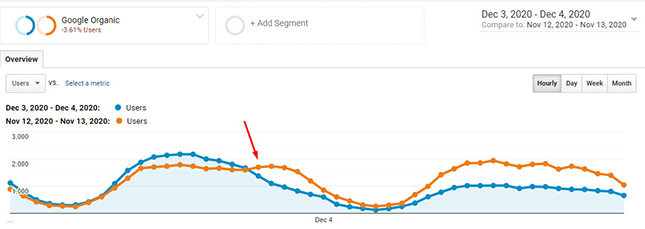

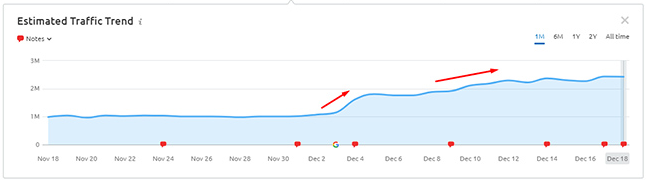

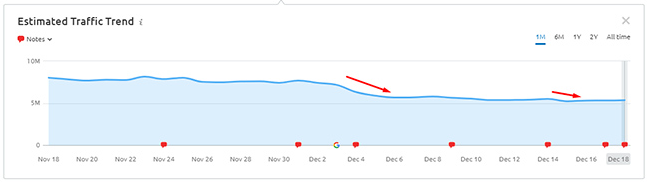

Zodra een brede kernupdate uitrolt, is het meestal een paar dagen voordat we veel beweging over de sites zien. Maar met de december-update zagen we al heel snel beweging (binnen 24 uur). Een aantal mensen (waaronder ikzelf) deelden elk uur de trend van Google Analytics van sites die de impact van de update begonnen te zien. Bijvoorbeeld:

Veel sites die werden getroffen, zagen een tonnenlange beweging (ofwel schommelen ofwel vallen) direct na de update op 12/4 en 12/5. Daarna werd het wat rustiger. Het was bijna te rustig na die eerste volatiliteitsgolf. Maar toen kwam 12/9 rond. Ik zal die volatiliteit in het volgende deel behandelen.

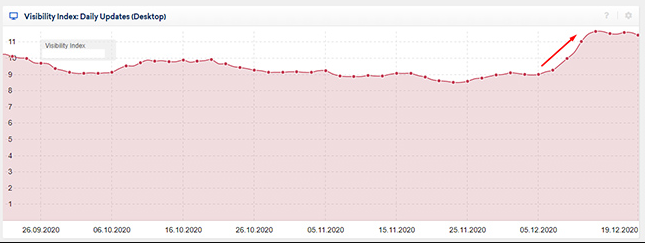

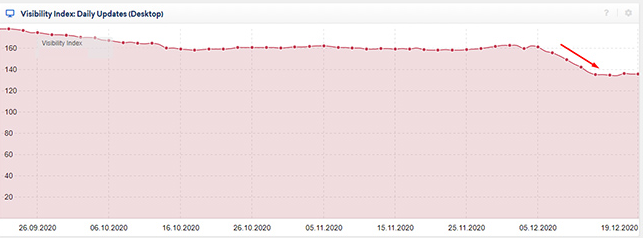

Hier zijn twee voorbeelden van pieken en dalen na het uitrollen van de update. Sommige waren dramatisch en ik zal hier meer over vertellen in de case studies in deel twee van de serie. Beide voorbeelden hieronder zijn overigens zeer interessant.

Sidderingen en omkeringen:

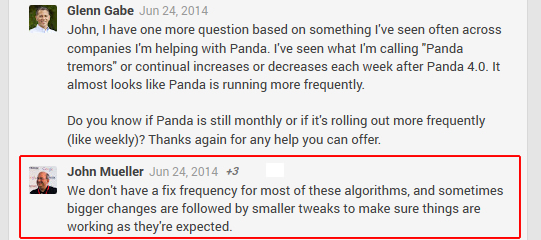

Nogmaals, ik bleef bij mezelf denken dat dit snel was… bijna te snel, wat me ook herinnerde aan een belangrijk punt dat John Mueller jaren geleden bevestigde over grote algoritme-updates. Na de middeleeuwse Panda-updates zag ik soms vreemde schommelingen na de uitrol. Bijvoorbeeld, duidelijke en grote veranderingen in de ranglijst enkele dagen na de uitrol (soms zelfs het omkeren van de koers).

Toen ik John hierover vroeg, legde hij uit dat Google kleinere tweaks kan implementeren na de uitrol van grote algoritme-updates op basis van wat ze zagen. Dat was volkomen logisch en ik noemde ze toen “Panda tremors”. Ik weet zeker dat dezelfde aanpak geldt voor brede kernupdates en ik geloof dat we dat ook hebben gezien met de update van december 2020. Vanaf 12/9 zagen we veel extra volatiliteit, waarbij veel sites meer beweging in dezelfde richting zagen. Bijvoorbeeld:

En hier is John die meer uitlegt over wat ik “sidderingen” noem:

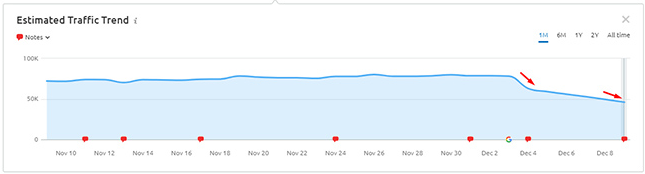

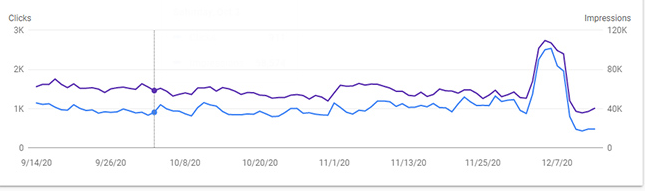

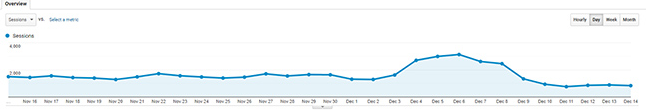

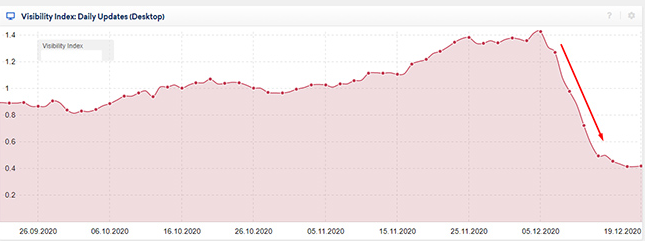

Maar, we zagen ook een aantal sites in omgekeerde richting gaan. En sommige volledig omgekeerd. Het was wild om te zien. Toen ik eenmaal had gedeeld wat ik zag, had ik een aantal bedrijven die me uitlegden wat er met hun eigen sites gebeurde! En verschillende bedrijven stuurden screenshots van Google Analytics en Google Search Console (GSC) die de omkeringen lieten zien.

Zoals je je kunt voorstellen, was dit ongelooflijk teleurstellend voor die site-eigenaren (en moeilijk voor hen om mee te maken). Stel je voor dat je aan het schommelen was met de update, om vervolgens terug te vallen naar waar je was voor de update (en sommige zijn zelfs nog verder gedaald!) Hier zijn enkele screenshots van de omkeringen van GSC en Google Analytics:

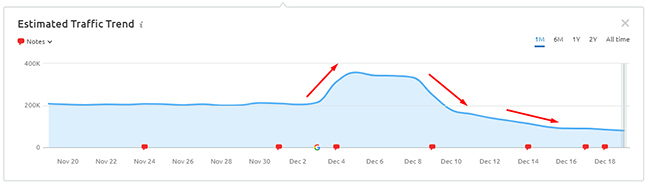

En hier is hoe de zoekzichtbaarheid eruit ziet voor een van die sites. Krankzinnig:

Major Affiliate Impact met Reversals:

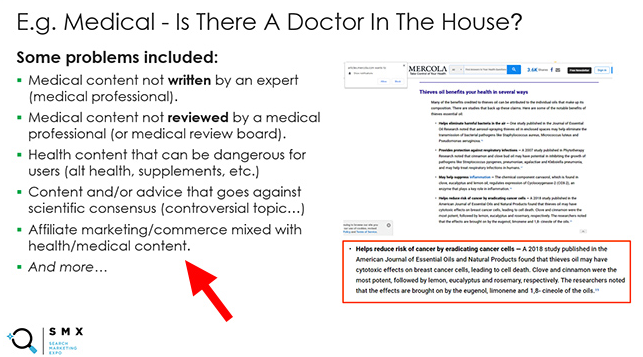

Het is de moeite waard om op te merken dat een aantal affiliate sites een enorme volatiliteit zagen met de december-update, en zelfs meer dan normaal (naar mijn mening). En sommige werden beïnvloed door de omkeringen die ik net heb behandeld. En dan binnen affiliate marketing, die gericht zijn op gezondheid en medische zag een ton van de volatiliteit.

Op dat punt noemde ik een belangrijk punt in mijn SMX Virtual slides over affiliate marketing en gezondheid/medische sites. Ik legde uit dat YMYL (Your Money or Your Life) inhoud aan een hogere standaard wordt gehouden. En wanneer je handel of affiliate marketing mengt met gezondheid en medisch, is er een dunne lijn tussen educatie en verkoop. Ik zag een aantal sites in deze situatie absoluut worden gerookt door de kernupdate van december 2020. Pas op.

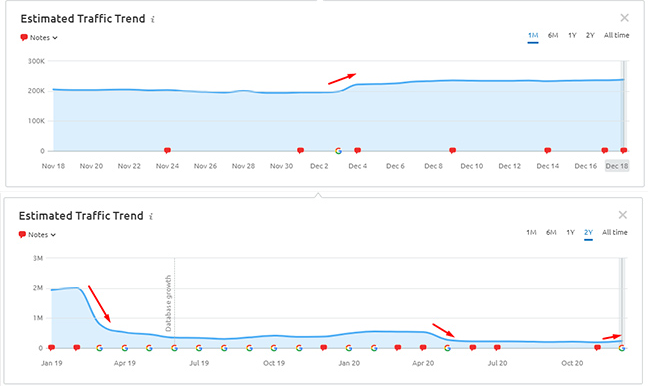

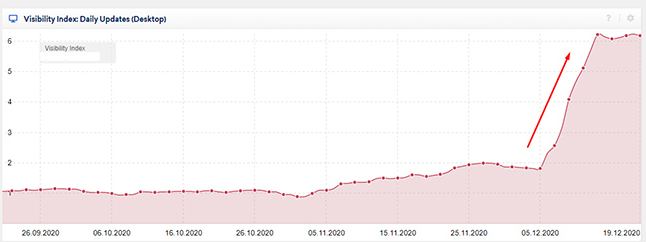

Sommige alternatieve geneeskundelocaties zien een verbetering, maar nog steeds een grote stap terug ten opzichte van de vorige niveaus:

Er waren enkele alternatieve geneeskundelocaties die met de kernupdate van december een mooie stijging zagen. Als u zich herinnert, hebben veel van deze sites in het verleden aanzienlijke dalingen gezien, vooral te beginnen met de Medic Update in augustus 2018. Dat was interessant om te zien, maar je moet uitzoomen om te zien hoe ver ze zijn teruggekomen (of niet). Hoewel sommigen wel mooie stijgingen zagen tijdens deze update, zijn ze nog steeds ver onder het niveau van voorheen. Gewoon een interessante kanttekening.

Zo is er bijvoorbeeld een mooie hobbel in de zichtbaarheid tijdens de december-update, maar die verbleekt in vergelijking met waar de site ooit was.

Een huismiddeltje sub-niche als een microkosmos van de volatiliteit van de alt-geneeskunde:

Ik heb ook een goed voorbeeld gegeven dat de waanzinnige volatiliteit laat zien die een specifieke niche kan zien met brede kernupdates. Binnen de alternatieve geneeskunde is er een subniche huismiddel waar veel sites zich op richten. Deze ruimte zag een ongelooflijke hoeveelheid volatiliteit, met veel sites die van een klif vallen. Zoals bij veel huismiddeltjes zijn er enkele claims die niet door de wetenschap worden ondersteund en die gevaarlijk kunnen zijn om te volgen. Vergeet niet dat de YMYL-inhoud op een hoger niveau wordt gehouden.

Hier zijn enkele voorbeelden van de volatiliteit in die niche:

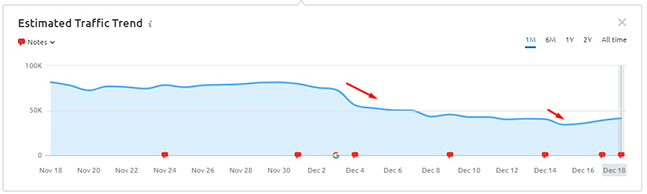

Een aantal grote e-Commerce Spelers schommelen en vallen:

Weet je nog dat ik de timing van deze update eerder noemde? Nou, sommige grote e-commerce sites deden het niet goed tijdens de update. Het enige goede voor hen is dat het in ieder geval niet goed was voor de Thanksgiving-week met Zwarte Vrijdag en Cybermaandag in aantocht. Hoewel ze zijn gezakt, konden andere e-commerce sites die wachten op herstel tijdens het vakantieseizoen wel aan zichtbaarheid winnen. Nogmaals, ik denk dat dit eerlijk was. Sommige sites waren bijna zeven maanden aan het wachten om te herstellen.

Hier zijn twee grote spelers in e-commerce met zeer verschillende resultaten op basis van de december-update:

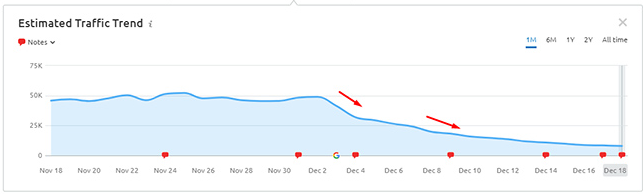

Online Games, Lyrics, en Coupons With Major Volatility (en een waarschuwing voor sites met dezelfde, of zeer gelijkaardige inhoud als andere sites):

Ik wilde de online spelletjes niche voor een minuut noemen (en andere categorieën zoals het). Het is een moeilijk gebied omdat veel van de sites dezelfde of zeer vergelijkbare inhoud bevatten. Ik heb deze situatie ook behandeld in mijn SMX Virtual-presentatie.

Google’s John Mueller heeft uitgelegd dat als je dezelfde inhoud, of zeer vergelijkbare inhoud, aan veel andere sites op het web levert, dan is het moeilijk voor Google’s algoritmes om te bepalen welke site moet worden gerangschikt. En dat kan leiden tot veel volatiliteit in de loop van de tijd. Het is super belangrijk om uw site zo veel mogelijk te differentiëren.

Nou, de online games niche zag een aantal gekke beweging met de december-update. Als uw site zich in deze situatie bevindt (met dezelfde of zeer vergelijkbare inhoud als veel andere sites), dan raad ik u ten zeerste aan om te proberen uw site zo veel mogelijk te differentiëren, een of andere vorm van toegevoegde waarde te bieden voor gebruikers, enz. Zo niet, dan kunt u uiteindelijk een soortgelijke zichtbaarheid zien die vergelijkbaar is met de onderstaande voorbeelden. Helaas zullen er flinterdunne marges zijn tussen de sites (scoring-wise en rankings-wise). Let op.

Nieuws Uitgeverij Volatiliteit:

Er zijn altijd veel bewegende delen met grootschalige nieuwssites. Miljoenen pagina’s geïndexeerd, tientallen miljoenen pagina’s als je rekening houdt met de crawlable footprint van elke site, misschien een advertentie situatie die agressief en storend kan zijn, sites proberen een balans te vinden tussen informatie, UX, en monetisatie. Ik heb geholpen veel nieuws uitgevers door de jaren heen en er zijn typisch veel dingen die ik opduiken tijdens die audits te verbeteren.

Hier is wat volatiliteit uit de ruimte (en dit is voordat het Page Experience Signal uitrolt, dat is mei 2021). Ik breng dat naar voren omdat nieuwssites vaak veel problemen hebben op basis van de factoren en subfactoren die betrokken zijn bij het Page Experience Signal (dus het zou interessant moeten zijn om te zien hoe nieuwsuitgevers worden beïnvloed als het eenmaal uitrolt). Ik heb ook de sub-signalen behandeld in een Web Story eerder dit jaar als je daar meer over wilt weten.

Meer kernpunten over Broad Core Updates & Mijn SMX Virtuele Presentatie:

In mijn bericht over de brede kernupdate van mei 2020 heb ik een aantal belangrijke punten opgenomen voor site-eigenaren om inzicht te krijgen in de brede kernupdates van Google. Deze punten leken te resoneren met site-eigenaren, omdat het onderwerp extreem genuanceerd is en site-eigenaren uiteindelijk in de war kunnen raken over hoe ze uitrollen, wat Google evalueert, en wanneer je het herstel kunt zien.

Die heb ik ook opgenomen in mijn SMX Virtual presentatie (gepresenteerd op 12/8), maar ik heb ook meer items aan de lijst toegevoegd. Die extra punten neem ik hieronder op. Ik raad u zeker aan om mijn bericht over de May broad core update te lezen, zodat u alle belangrijke punten over deze updates kunt begrijpen.

- Er is Never One Smoking Gun – Bij het bekijken van een site die zwaar is getroffen door een brede kernupdate, is er nooit een rokend pistool, er is meestal een batterij van hen.

- Relevantie-aanpassingen – Google kan relevantie-aanpassingen uitvoeren tijdens brede core-updates, die niet noodzakelijkerwijs een slechte zaak zijn voor uw site. Graaf in de drop en zoek objectief uit of er grote relevantie aanpassingen zijn gedaan (zoals uw site ranking voor queries waar het geen juiste ranking voor had), of als er diepere problemen in het spel zijn.

- “Miljoenen babyalgoritmen…” – Google’s Gary Illyes legde in 2019 in Pubcon uit dat het kernalgoritme van Google bestaat uit “miljoenen babyalgoritmen die samenwerken om een score te halen”. Ik hou van dat citaat en het is de reden waarom je nooit één kwestie kunt aanwijzen die een site doorzeeft vanuit een breed kernupdate standpunt.

- Herstel – Je kunt meestal niet herstellen totdat er weer een brede kernupdate uitrolt. Dit is super belangrijk om te begrijpen. Als uw site zwaar is getroffen door een brede core-update, moet u de site op de lange termijn aanzienlijk verbeteren. Dat is waar Google naar op zoek is en dat ziet u (meestal) alleen terug tijdens de volgende brede core-updates.

- Recente wijzigingen worden niet weergegeven – Recente wijzigingen worden niet weergegeven in brede core-updates. Google’s John Mueller heeft dit in het verleden uitgelegd, en zelfs nog eens in een recente Search Central Hangout. Wijzigingen die u bijvoorbeeld 2-3 weken voor een brede core-update doorvoert, worden doorgaans niet weergegeven in die update. Google evalueert vele factoren over een lange periode met brede core-updates. Het gaat niet om die recente aanpassing of verandering die je hebt aangebracht.

En nu op basis van mijn SMX Virtuele presentatie, ben ik met een aantal extra belangrijke punten die site-eigenaren moeten begrijpen over brede core updates. Nogmaals, dit zijn fundamentele punten die u moet begrijpen voordat u de sanering aanpakt:

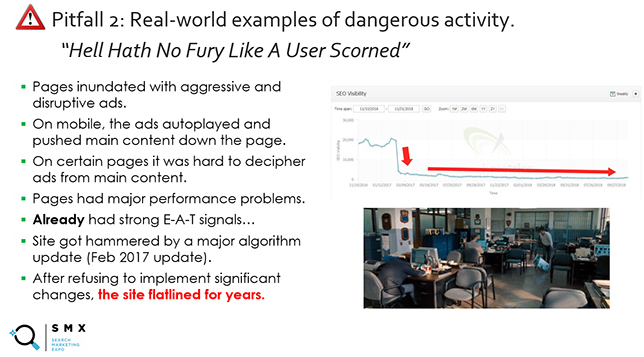

Agressieve Ads en “De hel heeft geen woede zoals een gebruiker die wordt geminacht”:

Ik zie nog steeds vreselijke gebruikerservaringen op veel sites die zwaar worden beïnvloed door brede kernupdates. Agressieve, verstorende en misleidende advertenties leveren een vreselijke UX op voor veel mensen. Doe dit niet. Je kunt een zware prijs betalen. Google heeft zelfs agressieve advertenties genoemd in zijn eigen blogpost over brede core-updates. Onthoud altijd, en respecteer, je gebruikers.

Hieronder is een slide van mijn SMX presentatie waar ik een veel voorkomende valkuil behandel die ik zie bij sites die zwaar getroffen worden door brede core updates. Dit ging over een specifieke site, maar ik zie dit vaak.

Het grijze gebied van Google’s Algoritmen (en Yo-Yo Trending):

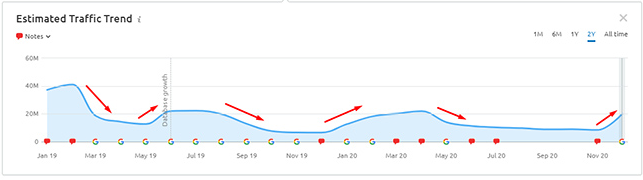

Voor sites die in het grijze gebied van Google’s algoritmen surfen, is het gemakkelijk om tijdens de volgende brede kernupdates te blijven pieken en dalen. Bijvoorbeeld, die vallen in januari, schommelen in mei, om vervolgens weer te vallen in december (of vice versa). Daarom is het super belangrijk om uw site op de lange termijn aanzienlijk te verbeteren. U wilt duidelijk uit het grijze gebied komen, zodat u de volatiliteit in de toekomst kunt beperken. Er zijn veel voorbeelden van sites die ofwel niet significant zijn verbeterd, of die meer problemen hebben geïnjecteerd in hun sites die dit soort bewegingen blijven zien.

En aan de andere kant, waren er zeker sites die niets deden om te verbeteren en schommelden. Maar naar mijn mening, tenzij ze uit het grijze gebied komen, kunnen ze heel goed weer druppels zien. Ik heb het grijze gebied in het verleden zwaar bedekt en het is een gekmakende plek om te wonen voor de eigenaren van de site. Ik zal ook een heel bijzondere casestudy behandelen in deel twee van deze serie die in deze categorie viel.

Pas op voor technische SEO-problemen die kwaliteitsproblemen veroorzaken:

Er waren verschillende voorbeelden die ik heb opgepikt met de brede kernupdate van deze happening in december en het kan sinister zijn, omdat het onder de oppervlakte kan zitten zonder dat de eigenaars van de site zich realiseren dat het gebeurt. Ik heb dit ook in mijn SMX Virtual presentatie behandeld, en ik kreeg in de Q&A verschillende vragen over het verduidelijken van wat ik bedoel.

Ter verduidelijking, ik heb het NIET over fundamentele technische SEO problemen. Ik heb het over technische SEO problemen die kwaliteitsproblemen veroorzaken. Google legt uit dat elke geïndexeerde pagina in aanmerking wordt genomen bij de beoordeling van de kwaliteit. Dus, als u zakken met pagina’s heeft die worden gepubliceerd vanwege technische SEO problemen, en die pagina’s zijn van lage kwaliteit en/of dun, en ze worden geïndexeerd, dan is dat waar ik naar verwijs.

Bijvoorbeeld, het strippen van noindex voor duizenden pagina’s van lage kwaliteit per ongeluk, het hebben van grote canonieke problemen en het indexeren van veel extra pagina’s die niet geïndexeerd zouden moeten worden, het verkeerd gebruiken van parameters of sessie-ID’s waardoor Google veel extra url’s van lage kwaliteit vindt, enzovoort. Daarom is het ontzettend belangrijk om uw site grondig te analyseren via de lens van brede core-updates. Als je die onderliggende problemen mist, kun je je wielen laten draaien zonder dat je weet wat er aan de hand is.

Het is ook de moeite waard om op te merken dat Google’s John Mueller op SMX Virtual presenteerde en enkele tips gaf voor 2021. In die tips legde hij uit dat in 2021 en daarna, sites die “technisch beter” zijn een voordeel hebben. Soms is dat een klein voordeel, maar afhankelijk van de niche kan het groter zijn. Hij zei dat het goed is om dat voordeel te krijgen. Vergeet niet dat de inhoud koning is, maar streef naar sterke technische SEO. Hier is een tweet die ik heb gedeeld toen ik John’s presentatie van SMX Virtual behandelde:

Great presentation from @johnmu at #SMX Virtual. Here’s a thread with some interesting information. 🙂

— Glenn Gabe (@glenngabe) December 8, 2020

Some ranking changes in 2021 (like core updates) will be harder/trickier to explain. Also, some updates will be aimed at helping “less SEO savvy sites”. pic.twitter.com/G5cSIBQYuU

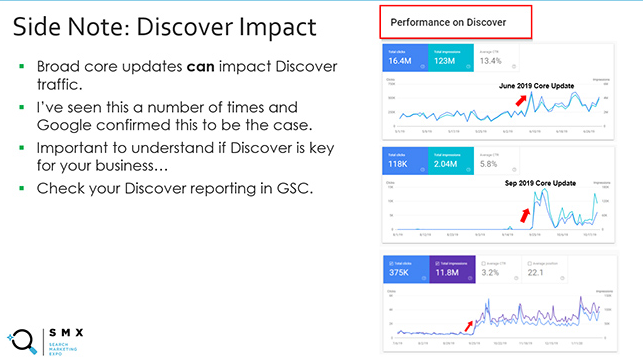

Google Discover en Top Stories Visibility kan worden beïnvloed:

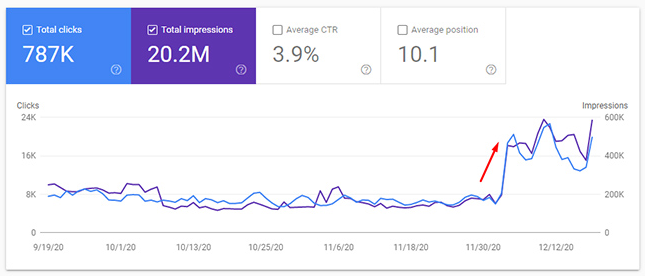

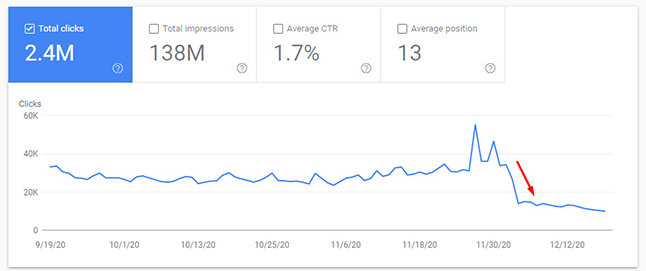

Ik heb dit al eerder behandeld en het is belangrijk om te begrijpen dat de zichtbaarheid van zowel Discover als Top Stories kan worden beïnvloed door brede kernupdates. Dus als de Discover-feed of Top Stories-functie van Google belangrijk is voor uw bedrijf, dan moet u na een brede kernupdate goed kijken naar uw zichtbaarheid.

Hieronder vindt u bijvoorbeeld enkele voorbeelden van Discover-verkeer dat wordt beïnvloed door een brede core-update. Let op de duidelijke upticks in clicks en impressies direct na het uitrollen van een brede core-update:

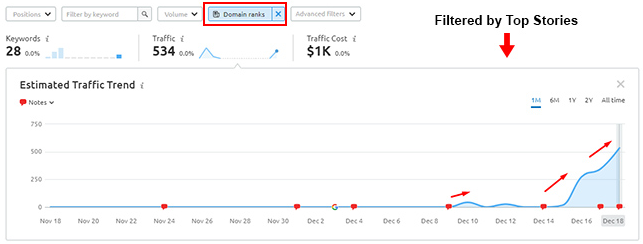

En hier is Top Stories zichtbaarheid voor een site na de december update. Let wel, ze waren nog nooit eerder in Top Stories te vinden. Ze stonden vrij goed in Google News, maar hebben moeite gehad om in te breken in Top Stories. Dit was een goed teken voor het bedrijf, dat hard heeft gewerkt om te verbeteren (na in 2019 geraakt te zijn door een brede kernupdate, die zich tijdens een volgende update herstelde en sindsdien verder is verbeterd). Het is niet veel zichtbaarheid, maar opnieuw waren ze nooit eerder (ooit) in Top Stories:

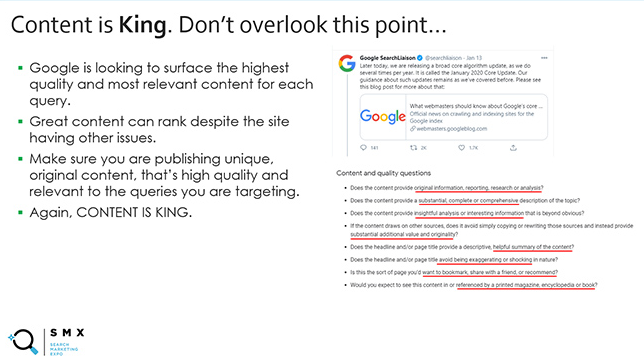

De inhoud is King: Uiterst relevante inhoud kan ondanks andere problemen op de ranglijst staan.

Google is altijd op zoek naar de hoogste kwaliteit en de meest relevante inhoud voor elke zoekopdracht. Google heeft herhaald dat site-eigenaren zich moeten richten op het bouwen van de beste inhoud op basis van wat gebruikers zoeken. Vergeet dit punt niet.

Geweldige inhoud kan nog steeds winnen ondanks dat de site andere grote problemen heeft. Dit is de reden waarom u kunt zien dat sommige sites met veel problemen nog steeds in de ranglijst staan en niet zwaar worden getroffen door kernupdates. Er zijn veel factoren die worden geëvalueerd en als een site de meest relevante inhoud voor gebruikers produceert, kan Google die site uiteindelijk nog steeds hoog in de lijst met vragen plaatsen. U kunt dit ook zien bij sites die veel autoriteit hebben. Ze kunnen ondanks het feit dat ze andere zaken hebben, toch een ranking krijgen.

Dit is ook de reden waarom het belangrijk is om niet blindelings andere sites te volgen die het goed lijken te doen. Je zou ze direct van een klif kunnen volgen. Jouw site is anders dan die van hen. Je komt misschien niet weg met wat ze krijgen. En als je dat niet doet, zou je zwaar kunnen vallen als er een brede kernupdate uitrolt.

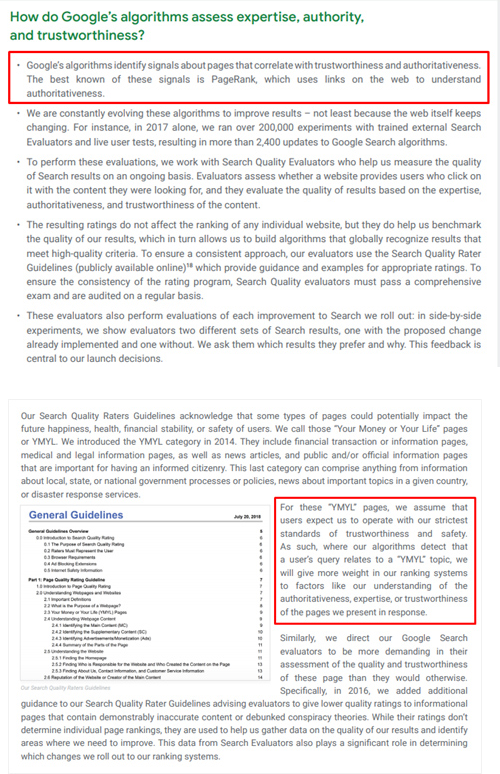

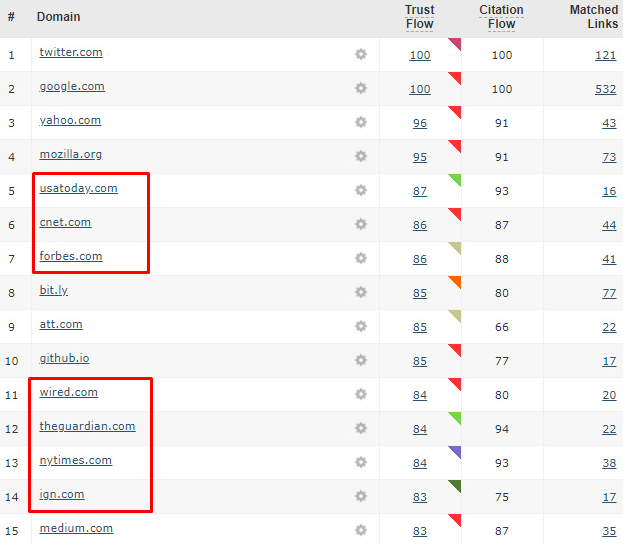

De A in E-A-T en de kracht van de juiste links:

Bij het analyseren van specifieke druppels en winsten in een verticale, is het soms duidelijk dat bepaalde sites een enorme hoeveelheid autoriteit hebben (en andere minder gezaghebbende sites hebben moeite om met hen te concurreren). Google heeft bijvoorbeeld uitgelegd dat de A in E-A-T sterk wordt beïnvloed door PageRank (of links van het web). Zij hebben dit uitgelegd in een whitepaper over de bestrijding van desinformatie die in 2019 werd gepubliceerd (screenshots hieronder).

Ook Google’s Gary Illyes legde ooit in Pubcon uit dat E-A-T grotendeels gebaseerd was op links en vermeldingen van bekende sites. Dus als Google probeert te begrijpen hoe gezaghebbend een site is, dan is het hebben van de juiste links van belang. Het gaat niet om kwantiteit, maar om kwaliteit. En daarom kun je deze situatie niet gemakkelijk oplossen als je op dit moment niet veel gezag hebt…

Je kunt bijvoorbeeld niet zomaar links en vermeldingen krijgen van krachtige sites op het web (zoals CNN, The New York Times, of nog kleinere sites binnen een niche die veel autoriteit hebben). Dat moet je op een natuurlijke manier verdienen door de juiste dingen inhoudelijk, promotioneel, etc. te doen.

Het is de moeite waard om op te merken dat ik dit in actie heb gezien met de brede kernupdate van december. Ik vergeleek een site die hard was geraakt met de sites die nu op de topplekken staan en het was heel duidelijk dat er daar een gezagsverschil was. Eén site had minder dan 1K links in totaal en niet veel van extreem gezaghebbende sites, terwijl de andere miljoenen links hadden, waaronder veel van enkele van de meest gezaghebbende sites op het web.

Hieronder staat een screenshot van Majestic’s Solo Links waar je de toplinks van elke site kunt vergelijken. Het gaat nooit over één ding… maar het kan moeilijk zijn om te concurreren tegen sites met een enorme hoeveelheid autoriteit.

Hieronder zie je enkele van de topdomeinen die linken naar een andere site die goed scoort op veel van de topvragen, maar niet linkt naar de site die is weggevallen. Nogmaals, het gaat nooit om één ding, maar autoriteit is belangrijk:

De gebruikelijke verdachten:

Ik heb dit al vele malen behandeld in mijn berichten over kernupdates, maar het is de moeite waard om het hier nog eens te vermelden. Als u op zoek bent naar manieren om uw site te verbeteren, dan is het belangrijk om te kijken naar wat ik “The Usual Suspects” noem. Het is een geweldige film, maar het is niet zo geweldig voor core updates. 🙂

Google heeft vastgelegd dat het de kwaliteit op de lange termijn aanzienlijk wil verbeteren, zodat er tijdens de volgende core-updates winst kan worden geboekt. Daarom is het belangrijk om alle mogelijke problemen aan de oppervlakte te brengen en er zoveel mogelijk aan te pakken. Dit sluit aan bij de “Kitchen Sink”-aanpak van de sanering, die ik in veel van mijn berichten over brede core-updates heb behandeld.

- alle laagwaardige of dunne inhoud op de site opjagen en dat aanpakken.

- Eventuele barrières voor de gebruikerservaring op de site opheffen.

- Zorg ervoor dat je geen agressieve, storende of misleidende reclame-ervaring hebt (ik heb dit eerder genoemd).

- Bekijk de site vanuit een E-A-T-perspectief (deskundigheid, gezaghebbendheid en vertrouwen). Dat wil zeggen dat het de site aan E-A-T kan ontbreken, wat een genuanceerd onderwerp is dat veel site-eigenaren in verwarring brengt. Ook is E-A-T zwaarder gewogen voor YMYL-vragen, dus het is super belangrijk om dit te begrijpen als u zich richt op een YMYL-onderwerp.

- Ga op zoek naar technische SEO problemen die kwaliteitsproblemen veroorzaken. Ik heb dit al eerder behandeld.

- En nogmaals, begrijp dat er relevantie-aanpassingen kunnen zijn, die misschien wel juist zijn. Bijvoorbeeld, misschien was je site wel aan het rangschikken voor zoekopdrachten waar hij geen goede ranking voor had. Als Google een relevantie-aanpassing doorvoert die invloed heeft op die vragen, dan is dat prima. Er is niets voor u te doen.

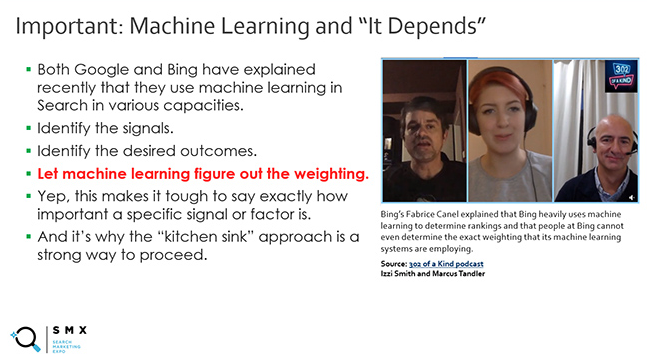

Machine-leren en “It Depends”:

En er is nog één onderwerp dat ik wilde behandelen voordat ik deel één van deze serie afrond. Zowel Google als Bing hebben onlangs uitgelegd dat ze in Search gebruik maken van machinaal leren in verschillende capaciteiten. Daar identificeren ze de signalen, identificeren ze de gewenste resultaten en laten ze vervolgens machinaal leren de weging van die signalen uitzoeken. Ja, ze laten het machinaal leren de weging van die signalen bepalen.

Dat is uiterst belangrijk om te begrijpen en daarom zou je Google en Bing vertegenwoordigers kunnen horen zeggen “het hangt ervan af” bij het beantwoorden van een vraag over hoe belangrijk iets is. Ze weten letterlijk niet wat de weging is, en de weging kan in de loop van de tijd zelfs veranderen. U kunt luisteren naar Fabrice Canel van Bing om dit uit te leggen in de 302 van een Kind podcast met Marcus Tandler en Izzi Smith (om 35:02 in de video).

Dit is ook de reden waarom het belangrijk is om uw site in zijn geheel te verbeteren. Concentreer je niet op één of twee dingen. Verbeter uw site aanzienlijk op de lange termijn. Dat is wat zowel Google als Bing willen zien.

Binnenkort: Deel 2 van de serie met 4 (Meer) casestudies die de complexiteit van Broad Core Updates benadrukken

Zoals ik al eerder in de post heb uitgelegd, zal ik binnenkort deel twee van deze serie publiceren, die vier interessante casestudies zal bevatten op basis van de brede kernupdate van december 2020. Mijn hoop is dat tussen deel een en twee, en mijn bericht over de kernupdate van mei, site-eigenaren een goed inzicht kunnen krijgen in wat Google doet met deze kernupdates, en hoe bepaalde sites worden aangepakt door eerdere updates. Kijk binnenkort voor deel twee.

We gaan verder: Tips en aanbevelingen voor site-eigenaren die worden beïnvloed door brede core-updates

Als u beïnvloed bent door de brede kernupdate van december, of door een eerdere kernupdate, lees dan zeker de volgende bullets met enkele tips en aanbevelingen. Ik weet dat het frustrerend kan zijn om een grote daling van de zichtbaarheid te zien en ik hoop dat je deze kogels nuttig vindt.

- Verbeter uw site in het algemeen, verander niet van kersenpluk. Google wil op lange termijn een aanzienlijke kwaliteitsverbetering zien.

- Vergeet niet dat er “miljoenen babyalgoritmen” zijn die samenwerken. Mis het bos niet door de bomen. Zorg ervoor dat alle potentiële problemen die de site zouden kunnen beïnvloeden objectief aan de oppervlakte komen.

- Gebruik een “keukengootsteen”-aanpak voor de sanering. Los het allemaal op (of zoveel als je kunt).

- Voer een gebruikersonderzoek uit door de lens van brede kernupdates. Ik kan niet genoeg benadrukken hoe krachtig dit kan zijn. Lees mijn casestudy en vorm een aanvalsplan. Het horen van echte gebruikers kan u helpen bij het identificeren van problemen die u gemakkelijk zou kunnen missen. U bent misschien te dicht bij uw eigen site.

- Lees en internaliseer informatie over E-A-T. Ik heb in mijn SMX Virtual presentatie vermeld dat zowel Lily Ray als Marie Haynes uitstekende informatie over E-A-T hebben gepubliceerd. Ik raad aan om die artikelen en presentaties door te nemen.

- Lees de Quality Rater Guidelines (QRG). Lees het dan nog eens. Het bevat 175 pagina’s SEO Gold. Het is een document gepubliceerd door Google dat uitlegt wat het beschouwt als hoge versus lage kwaliteit, waar raters naar moeten kijken bij het evalueren van sites, en nog veel meer. Als je het niet gelezen hebt, denk ik dat je het verhelderend zult vinden. 🙂

- Als u wordt beïnvloed door een brede kernupdate, moet u meestal wachten op een andere brede kernupdate om het herstel te zien. Rol dus geen veranderingen uit voor een paar weken en rol ze dan terug (na het niet zien van het herstel). Zo werkt het niet. Google is op record uit te leggen u (meestal) zal niet zien herstel tot een andere brede core update uitrolt, en alleen als je hebt aanzienlijk verbeterd de site.

- En het allerbelangrijkste is… GELDIGT UP. U kunt absoluut herstellen van deze updates. Het kost gewoon veel werk en tijd.